-

通常采用 正则化可以获取稀疏表达:

。

也有其他方法可以获取稀疏表达,如:正交匹配追踪:

其中

是 中非零项的个数。

当

被限定为正交矩阵时,该问题可以被高效解决。

通常可以构建两个模型:生成模型 (或者

) 与判别模型 ,其中生成模型与判别模型共享参数。

生成模型

(或者 ) 表达了对于监督学习问题解的先验知识。

即:

的结构通过共享参数的方式连接到 。

不需要将无监督学习和监督学习部分进行分离,二者位于同一个网络结构中。

-

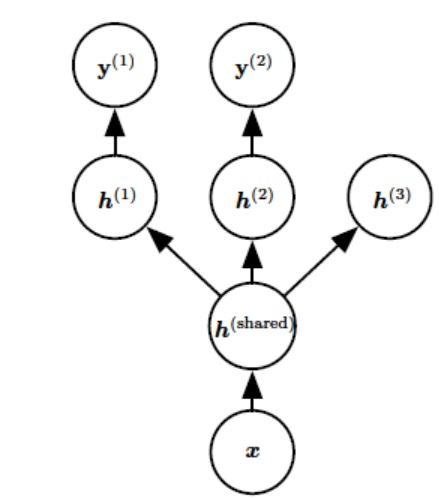

下图给出了多任务学习中的一个非常普遍的形式:有两个监督任务和一个无监督任务。所有的任务都共享相同的输入

和第一级中间层 ,具体的任务使用了具体的表示层。

因为共享参数,其统计强度大大提高因此能改进泛化能力。但是前提条件是:确实有某些信息在不同任务之间共享了。这要求不同任务之间存在某些统计关系。

多任务学习刻画了一个先验知识:这些不同的任务中,能解释数据变化的因子是跨任务共享的。

机器学习的许多线性问题(包括线性回归和),都依赖于求 的逆矩阵。

- 当

是可逆时,该问题有解析解。

- 当 是奇异矩阵时,该问题是欠定的。此时可以考虑正则化形式:求解

的逆矩阵。

- 当

使用正则化来解决欠定问题的思想超出了机器学习的范畴。